在人工智能大模型时代,如何在个人电脑上自由运行各类大语言模型?Ollama 正是为此而生的神奇工具!本文将带你体验 Ollama。

一、Ollama 简介

Ollama 是一个开源项目,核心使命是让用户在本地计算机(尤其是 macOS 和 Linux,Windows 也支持)上轻松运行、管理和与大语言模型(LLM)交互。

核心亮点:

一键运行: 无需复杂配置,一条命令即可下载并运行模型。

模型丰富: 支持 Llama 2、Mistral、Gemma、Phi-2、Qwen、Code Llama 等众多热门开源模型及其变体。

本地优先: 模型完全运行在本地机器上,保障数据隐私和安全。

跨平台支持: macOS、Linux 和 Windows 均可使用。

简单易用: 提供简洁的命令行界面 (CLI) 和兼容 OpenAI 的 API,便于集成。

高效运行: 内置优化,利用 CPU/GPU(特别是 Apple Silicon 的 GPU 加速),让模型在消费级硬件上也能运行流畅。

模型管理: 方便地查看、删除、复制本地模型库。

ollama

二、Ollama 安装

Ollama 的安装过程极其简单:

macOS 用户

访问官方网站:https://ollama.com/

点击页面上的 Download 按钮下载 .dmg 安装包。

双击下载的文件,将 Ollama 图标拖拽到 Applications 文件夹。

在 Applications 文件夹中找到 Ollama 并打开。首次运行时可能需要授权。

(推荐)打开终端,输入 ollama 确认安装成功。

Linux 用户

打开终端。

使用官方提供的一键安装脚本:

curl -fsSL https://ollama.com/install.sh | sh安装脚本会自动下载、安装并设置环境变量。

安装完成后,在终端输入 ollama 即可验证。

Windows 用户 (预览版)

访问下载页面:https://ollama.com/download

下载 Windows 预览版的安装程序 (.exe 文件)。

双击运行安装程序,按提示完成安装。

安装完成后,打开 命令提示符 或 PowerShell,输入 ollama 验证。

注意: Windows 预览版功能可能不如 macOS/Linux 完善,建议关注官方更新。

三、使用 Ollama

1. 下载并运行第一个模型

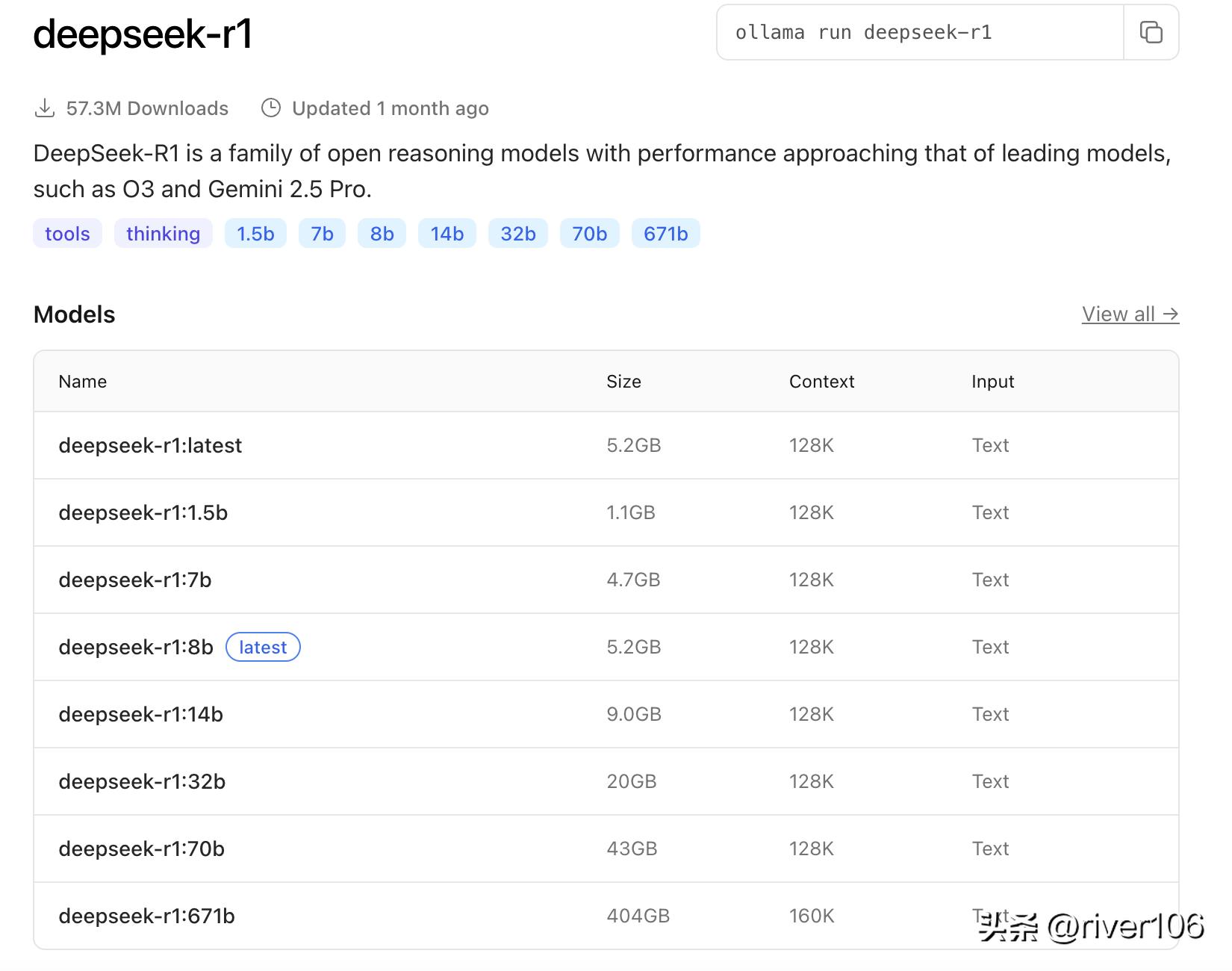

在Ollama的Models菜单下,找到deepseek-r1模型

deepseek-r1

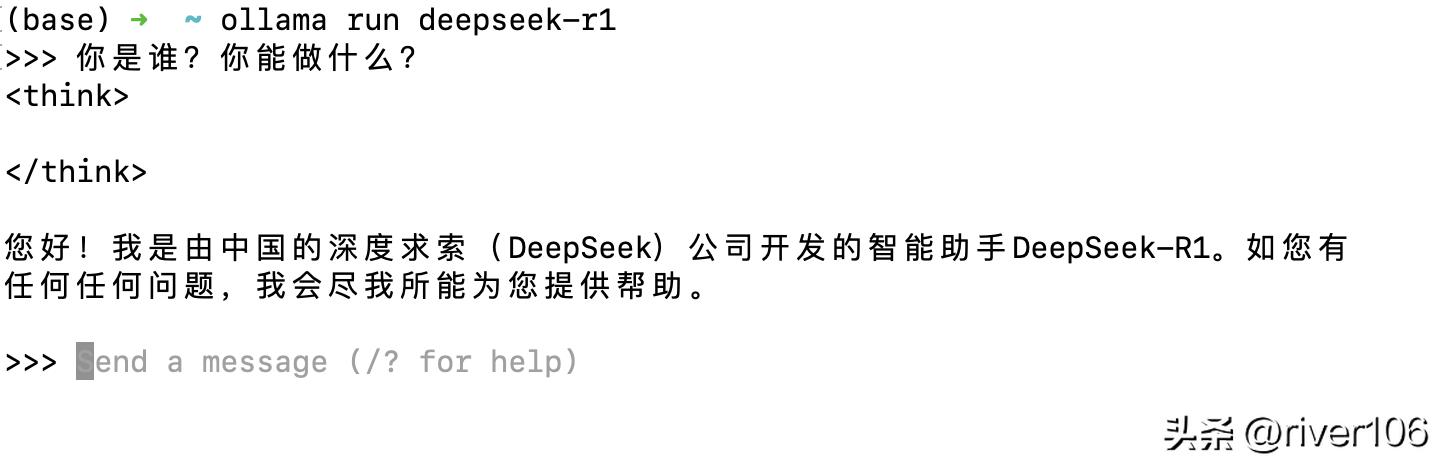

ollama run deepseek-r1ollama run 是核心命令, 首次运行会自动下载模型文件。

deepseek-r1 是模型名称, 不带参数默认是latest。

下载完成后,进入交互式聊天界面,输入你的问题或指令即可!

deepseek-r1

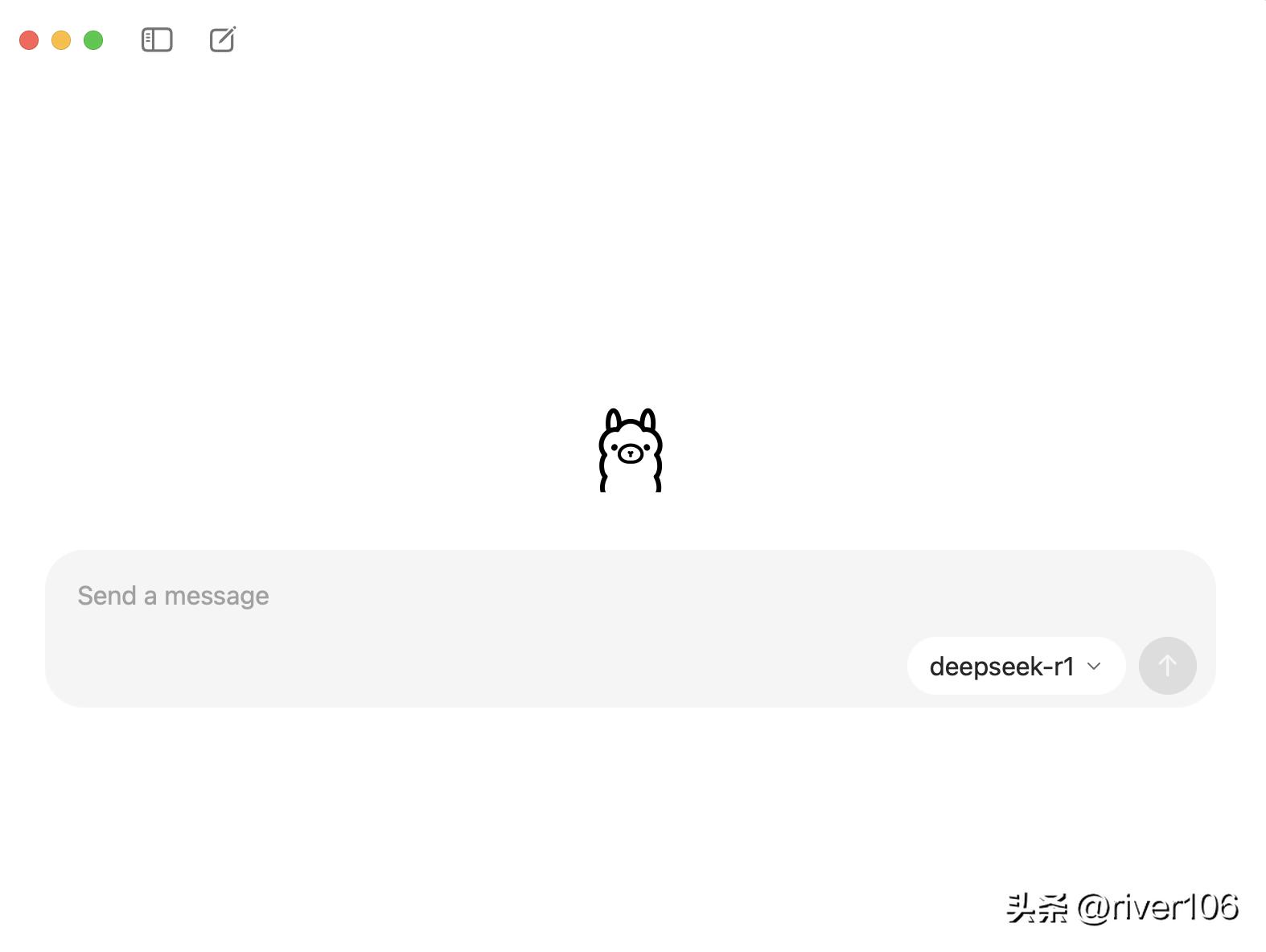

Ollama目前提供了图形化的聊天窗口:

2. 探索更多模型

Ollama 支持海量模型,尝试运行:

ollama run qwen3:8b # 运行通义千问 Qwen3 8B

ollama run gemma:7b # 运行 Google Gemma 7B

ollama run phi # 运行微软轻量级模型 Phi-2访问 Ollama Search 查看全部可用模型及其说明。

3. 模型管理命令

列出本地模型:

ollama list删除模型:

ollama rm <model-name> (例如 ollama rm qwen3:8b)4. Python API 调用

Ollama 兼容 OpenAI API 格式,轻松集成到 Python 项目中:

from openai import OpenAI

client = OpenAI(

base_url='http://localhost:11434/v1/', # Ollama 默认 API 地址

api_key='ollama', # 非必需,但需提供任意字符串

)

response = client.chat.completions.create(

model="qwen3:8b", # 指定本地运行的模型

messages=[

{"role": "user", "content": "你是谁?你能做什么?"}

]

)

print(response.choices[0].message.content)5. 与 Ollama Web UI 交互

Ollama 本身是命令行工具和UI,但社区开发了易用的 Web 界面:

安装官方 UI:

ollama serve # 确保 Ollama 后台运行

# 新开终端安装 Web UI

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v ollama-webui:/app/backend/data --name ollama-webui ghcr.io/ollama-webui/ollama-webui:main访问 http://localhost:3000 即可在浏览器中与模型聊天。

四、总结

Ollama 极大降低了在个人电脑上运行前沿大语言模型的门槛。无论你是开发者希望本地测试模型能力,还是普通用户追求更私密的 AI 对话体验,Ollama 都是绝佳选择。只需几分钟安装,一句命令就能召唤强大的 AI 助手!